作者/来源:新睿云小编 发布时间:2020-09-11

现今时代云计算机逐渐普及,深度学习与AI涉及到的数据集不断增加。可以预见的是未来计算机模型、网络模型也会越来越复杂,日后对于硬件设备与服务器的性能要求会越来越苛刻。

自建GPU服务器成本过高,则未来选择GPU服务器则成为了一大关。

熟悉深度学习的人都知道,深度学习是需要训练的,所谓的训练就是在成千上万个变量中寻找最佳值的计算。这需要通过不断的尝试识别,而最终获得的数值并非是人工确定的数字,而是一种常态的公式。通过这种像素级的学习,不断总结规律,计算机就可以实现像人一样思考。因而,更擅长并行计算和高带宽的-GPU,则成了大家关注的重点。

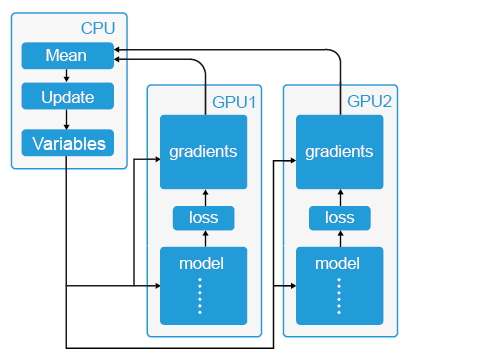

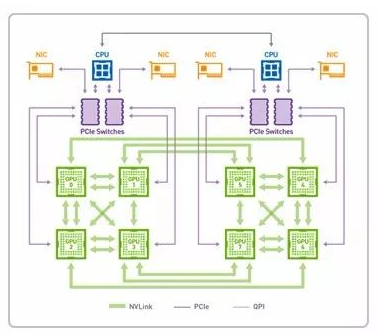

数据并行的原理很简单,如下图,其中-CPU-主要负责梯度平均和参数更新,而-GPU1和-GPU2-主要负责训练模型副本(model replica),这里称作“模型副本”是因为它们都是基于训练样例的子集训练得到的,模型之间具有一定的独立性。具体的训练步骤如下。

除了计算能力之外,GPU-另一个比较重要的优势就是他的内存结构。首先是共享内存。在-NVIDIA-披露的性能参数中,每个流处理器集群末端设有共享内存。相比于-CPU-每次操作数据都要返回内存再进行调用,GPU-线程之间的数据通讯不需要访问全局内存,而在共享内存中就可以直接访问。这种设置的带来最大的好处就是线程间通讯速度的提高(速度:共享内存>>全局内存)。

而在传统的CPU构架中,尽管有高速缓存(Cache)的存在,但是由于其容量较小,大量的数据只能存放在内存(RAM)中。进行数据处理时,数据要从内存中读取然后在-CPU-中运算最后返回内存中。由于构架的原因,二者之间的通信带宽通常在-60GB/s-左右徘徊。与之相比,大显存带宽的-GPU-具有更大的数据吞吐量。在大规模深度神经网络的训练中,必然带来更大的优势。

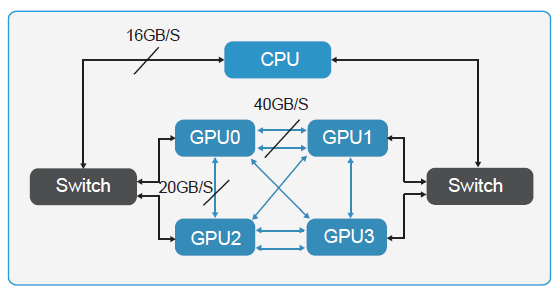

另一方面,如果要充分利用-GPU-资源处理海量数据,需要不断向-GPU-注入大量数据。目前,PCIe-的数据传输速度还无法跟上这一速度,如果想避免此类“交通拥堵”,提高数据传输速度可以选择应用-NVlink-技术的-GPU-卡片。

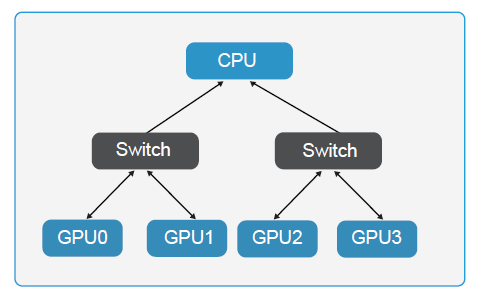

4-GPUs-with-PCIe

4-GPUs-with-NVLink

NVLink-是目前最快的-GPU-高速互联技术,借助这种技术,GPU-和-CPU-彼此之间的数据交换速度要比使用PCIe 时快-5-到-12-倍,应用程序的运行速度可加快两倍。通过-NVLink 连接两个-GPU-可使其通信速度提高至-80-GB/s,比之前快了-5-倍。

其中-Nvidia-的-Volta-架构计算卡使用的-NVLink-2.0-技术速度更快(20-25Gbps),单通道可提供-50-GB/S-的显存带宽。

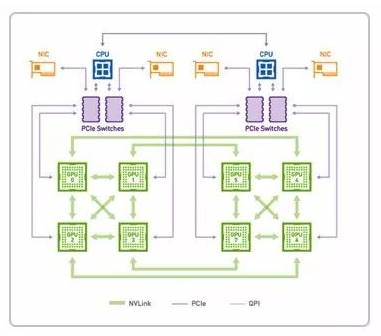

P100-NVLink1.0-数据传输模式

V100-NVLink2.0-数据传输模式

而且就目前而言,越来越多的深度学习标准库支持基于-GPU-的深度学习加速,通俗点描述就是深度学习的编程框架会自动根据-GPU-所具有的线程/Core-数,去自动分配数据的处理策略,从而达到优化深度学习的时间。而这些软件上的全面支持也是其它计算结构所欠缺的。

简单来看,选择-GPU-有四个重要参数:浮点运算能力、显存、数据传输。

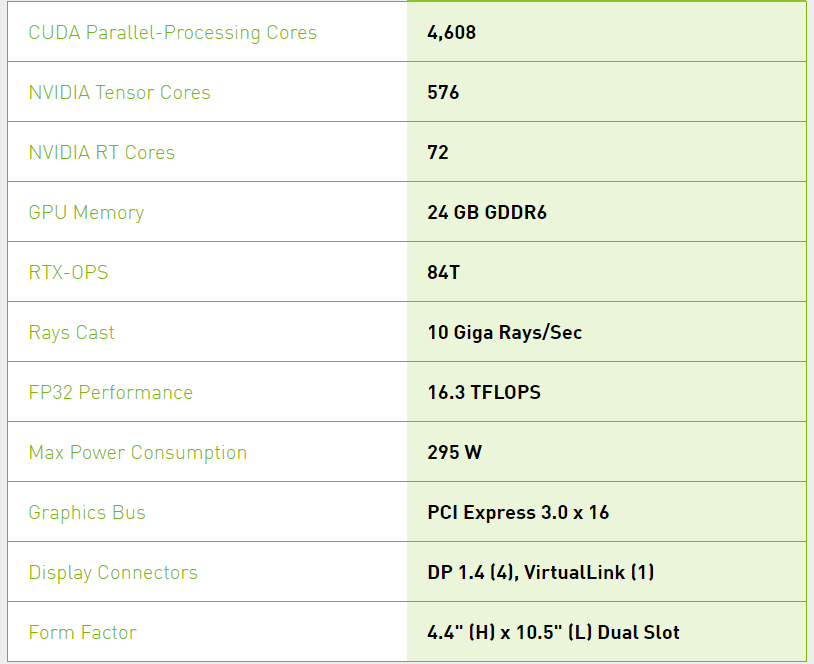

目前新睿云的香港云服务器均基于NVIDIA QUADRO RTX 6000

目前依托 NVIDIA Turing 架构和 NVIDIA RTX 平台,将 20 年来计算机图形领域取得的重大进步引入了专业工作流程。设计师和艺术家们现可利用硬件加速光线追踪、深度学习和先进的着色技术大幅提升工作效率,以空前速度创造出令人惊叹的内容。

QUADRO RTX NVLINK HB 桥接器

NVLink 让专业应用程序得以使用多 GPU 配置实现内存和性能的轻松扩展。使用 Quadro RTX NVLink HB 桥接器连接 2 块 RTX 6000 显卡,可实现高达 100 GB/秒的带宽和总计 48 GB 的 GDDR6 显存,从而能够处理更大的渲染、AI、虚拟现实或可视化工作负载。

目前新睿云的香港GPU服务器价格上也占有极大的优势: